La Commission européenne mobilise tous les acteurs pour encadrer l'intelligence artificielle

L'Union européenne franchit une étape cruciale dans la régulation de l'intelligence artificielle. La Commission européenne a lancé une vaste consultation publique pour définir les lignes directrices d'application de l'AI Act, le règlement révolutionnaire qui encadre les systèmes d'IA à haut risque. Cette démarche participative, ouverte jusqu'au 18 juillet, implique tous les acteurs du secteur dans la construction du cadre réglementaire le plus ambitieux au monde.

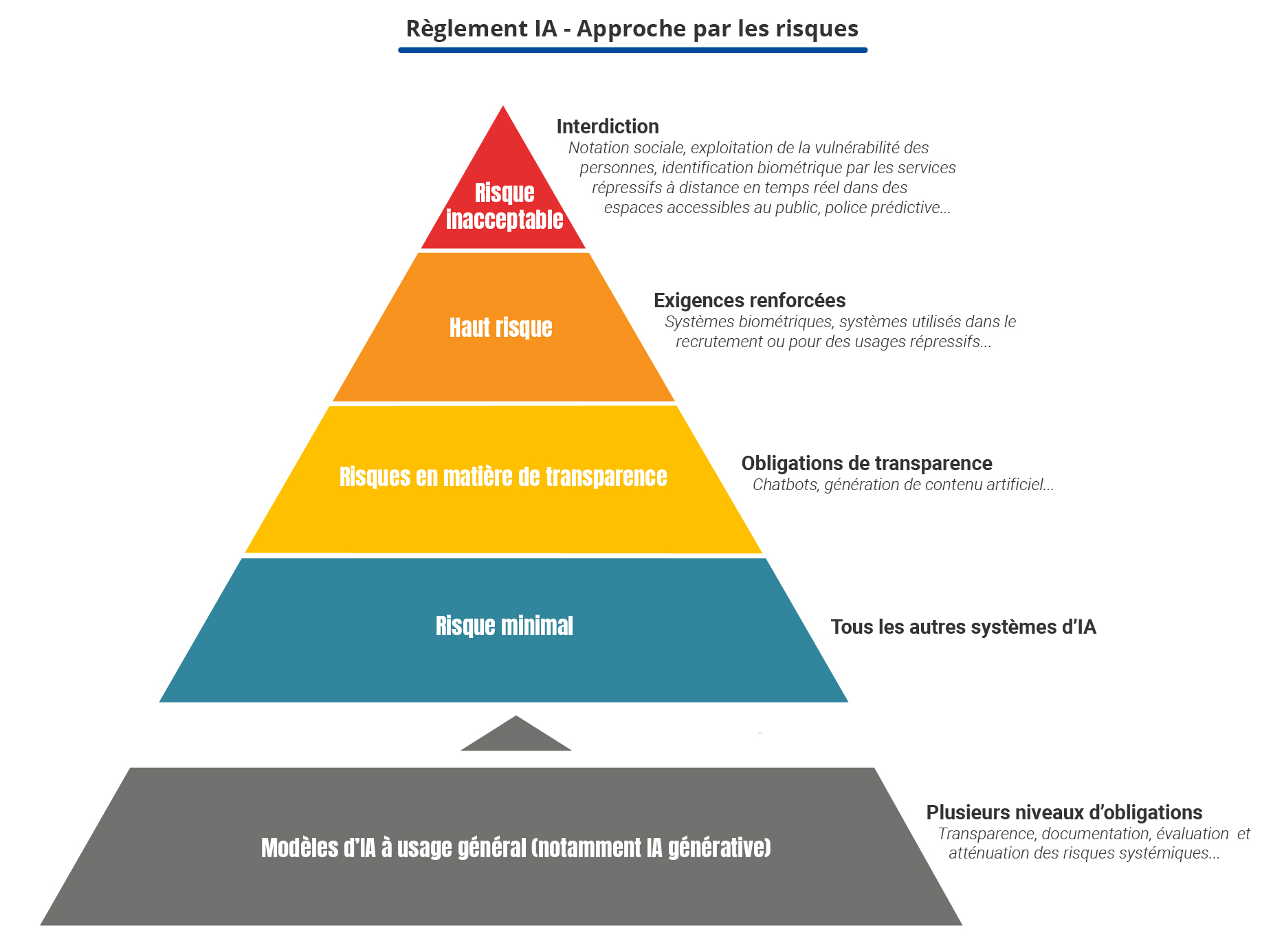

L'AI Act : Un cadre législatif progressif et structurant

Entré en vigueur le 1er août 2024, l'AI Act ou Règlement sur l'Intelligence Artificielle (RIA) constitue la première réglementation complète au monde sur l'IA. Son application se déploie selon un calendrier progressif s'étalant jusqu'en août 2027, permettant aux entreprises et institutions de s'adapter graduellement aux nouvelles exigences.

Les dispositions relatives aux systèmes d'IA à haut risque représentent le cœur de cette réglementation. Elles entreront pleinement en vigueur en août 2026, laissant aux acteurs économiques le temps nécessaire pour se conformer aux nouvelles obligations. Cette approche progressive témoigne de la volonté européenne de concilier innovation technologique et protection des citoyens.

Deux catégories distinctes de systèmes à haut risque

L'article 6 de l'AI Act établit une classification précise des systèmes d'intelligence artificielle considérés comme présentant un haut risque. Cette categorisation s'articule autour de deux axes principaux, reflétant la diversité des applications et des enjeux liés à l'IA.

La première catégorie englobe les systèmes d'IA destinés à être utilisés comme composants de sécurité d'un produit couvert par la législation d'harmonisation européenne mentionnée en annexe I, ou les systèmes qui constituent eux-mêmes un tel produit. Cette classification vise particulièrement les secteurs critiques où la sécurité constitue un enjeu majeur.

La seconde catégorie concerne les systèmes d'IA répertoriés à l'annexe III du règlement qui, par leur finalité spécifique, présentent un risque significatif pour la santé, la sécurité ou les droits fondamentaux des personnes. Cette approche fondée sur l'usage permet une régulation adaptée aux impacts potentiels de chaque application.

Une consultation participative sans précédent

La consultation publique lancée le 6 juin dernier illustre l'approche collaborative adoptée par la Commission européenne. Cette démarche participative vise à clarifier les critères de classification des systèmes à haut risque, mais également à préciser les obligations et responsabilités incombant aux différents acteurs impliqués dans leur développement et déploiement.

L'amplitude de cette consultation reflète la complexité des enjeux. Fournisseurs et développeurs de systèmes à haut risque, utilisateurs publics et privés, institutions académiques, centres de recherche, organisations de la société civile, autorités de surveillance et citoyens sont tous invités à contribuer à cette réflexion collective.

Cette approche inclusive permet à la Commission de recueillir des exemples d'usage concrets et d'identifier précisément les besoins opérationnels des acteurs du secteur. Elle garantit également que les futures lignes directrices correspondront aux réalités du terrain et aux défis pratiques rencontrés par les professionnels.

Des enjeux cruciaux pour l'écosystème technologique européen

La définition des lignes directrices pour l'application de l'article 6 revêt une importance stratégique majeure. Ces orientations détermineront concrètement comment les entreprises européennes et internationales opérant sur le marché européen devront concevoir, développer et déployer leurs systèmes d'IA.

L'impact économique de ces décisions sera considérable. Une classification trop restrictive pourrait freiner l'innovation et pénaliser la compétitivité européenne face aux géants américains et chinois. À l'inverse, des critères trop laxistes compromettraient l'objectif de protection des citoyens européens et la crédibilité du cadre réglementaire.

La Commission européenne doit donc trouver l'équilibre optimal entre protection des droits fondamentaux et préservation de l'innovation technologique. Cette équation complexe explique l'importance accordée à la consultation publique et la diversité des acteurs sollicités.

Les secteurs particulièrement concernés

Certains domaines d'application de l'IA font l'objet d'une attention particulière dans le cadre de cette réglementation. Les systèmes utilisés dans les secteurs de la santé, de l'éducation, de la justice, des ressources humaines, ou encore de la sécurité publique figurent parmi les candidats naturels à la classification "haut risque".

Les applications d'IA dans le recrutement, l'évaluation des performances professionnelles, l'octroi de crédits, ou les systèmes de reconnaissance biométrique soulèvent des questions particulièrement sensibles. Ces usages touchent directement aux droits fondamentaux et nécessitent un encadrement rigoureux.

Le secteur automobile, avec le développement des véhicules autonomes, constitue également un enjeu majeur. Les systèmes d'IA embarqués dans ces véhicules relèvent clairement de la catégorie des composants de sécurité critiques mentionnés dans l'article 6.

L'impact sur l'innovation et la compétitivité

La régulation européenne de l'IA s'inscrit dans un contexte de concurrence technologique mondiale intense. Les États-Unis et la Chine développent leurs propres approches réglementaires, créant un paysage normatif fragmenté qui complique les stratégies des entreprises multinationales.

L'Europe parie sur l'effet "Brussels Effect", espérant que ses standards élevés en matière de protection des données et des droits fondamentaux s'imposeront comme référence mondiale. Cette stratégie avait déjà porté ses fruits avec le RGPD, désormais source d'inspiration pour de nombreuses législations nationales.

Cependant, le défi consiste à éviter que cette réglementation ne décourage l'innovation ou ne pousse les entreprises technologiques à délocaliser leurs activités de recherche et développement vers des juridictions moins contraignantes.

Les obligations des fournisseurs et utilisateurs

Les futures lignes directrices devront préciser les responsabilités respectives des différents acteurs de la chaîne de valeur de l'IA. Les fournisseurs de systèmes à haut risque devront notamment démontrer la conformité de leurs solutions aux exigences de sécurité, de transparence et de supervision humaine.

Les utilisateurs, qu'ils soient publics ou privés, auront également des obligations spécifiques, notamment en matière de surveillance continue des performances et de signalement des incidents. Cette répartition des responsabilités constitue un enjeu crucial pour l'efficacité du dispositif réglementaire.

La question de la responsabilité en cas de dommages causés par un système d'IA défaillant reste particulièrement complexe. Les lignes directrices devront clarifier les mécanismes de recours et les procédures d'indemnisation des victimes.

Un calendrier serré pour un enjeu majeur

Avec une échéance fixée au 2 février 2026 pour la publication des lignes directrices, la Commission européenne dispose d'un délai relativement court pour analyser les contributions reçues et élaborer un cadre normatif cohérent. Cette contrainte temporelle reflète l'urgence de clarifier les règles du jeu pour les acteurs économiques.

La période de consultation, qui s'achève le 18 juillet, constitue donc une fenêtre d'opportunité cruciale pour tous les stakeholders souhaitant influencer le contenu de ces lignes directrices. Les contributions recueillies alimenteront directement les travaux de rédaction et détermineront l'orientation finale du texte.

Les défis de mise en œuvre pratique

Au-delà de la définition théorique des critères de classification, la Commission européenne doit anticiper les défis pratiques de mise en œuvre de la réglementation. L'évaluation de la conformité des systèmes d'IA, la certification des organismes d'évaluation, ou encore la coordination entre les autorités nationales constituent autant de chantiers complexes.

La dimension transfrontalière des services d'IA complique également l'application uniforme de la réglementation. Les entreprises opérant dans plusieurs États membres devront naviguer entre différentes interprétations nationales du cadre européen.

L'impact sur l'écosystème de l'IA générative

Cette régulation touche directement les modèles d'IA générative comme ChatGPT, qui sont classés comme systèmes d'IA à usage général. L'IA générative, comme ChatGPT, ne sera pas classée à haut risque, mais devra se conformer aux exigences de transparence et à la législation de l'UE sur le droit d'auteur.

Ces systèmes devront notamment indiquer que le contenu a été généré par l'IA, concevoir le modèle pour l'empêcher de générer du contenu illégal, publier des résumés des données protégées par le droit d'auteur utilisées pour la formation. Pour les modèles les plus avancés comme GPT-4, des évaluations approfondies et le signalement de tout incident grave à la Commission seront requis.

Cette nouvelle approche réglementaire représente un défi majeur pour les entreprises technologiques qui développent des solutions d'IA générative, les obligeant à repenser leurs processus de développement et de déploiement.

Les retards dans la mise en œuvre suscitent des inquiétudes

Malgré l'ambition du projet, la mise en œuvre de l'AI Act connaît plusieurs retards préoccupants. À deux mois de l'échéance du 2 août 2025, plus de la moitié des États membres de l'UE, dont la France, n'ont enfin pas encore désigné l'autorité nationale chargée de superviser la mise en œuvre de l'AI Act.

Le code de bonnes pratiques pour les modèles d'IA à usage général, initialement prévu pour mai 2025, a été repoussé à l'été, alors qu'il est censé entrer en vigueur le 2 août 2025. La multiplication de ces retards a conduit la Commission à émettre l'idée de dispositions transitoires voire d'un "arrêt des chronomètres", certains États comme la Pologne demandant même une suspension du règlement.

En France, la CNIL s'est positionnée pour exercer la mission d'autorité de surveillance, mais cette offre de service est restée sans écho du côté du gouvernement, illustrant les difficultés pratiques de mise en place du cadre réglementaire.

L'articulation avec le RGPD : Un défi de complémentarité

La régulation de l'IA s'articule étroitement avec le Règlement Général sur la Protection des Données (RGPD) déjà en vigueur. Contrairement à une idée répandue, l'AI Act ne remplace pas les exigences du RGPD mais vient les compléter en posant les conditions requises pour développer et déployer des systèmes d'IA de confiance.

Cette complémentarité crée quatre situations possibles : l'application du seul AI Act, du seul RGPD, des deux règlements simultanément, ou d'aucun des deux. Pour les entreprises, cette articulation complexe nécessite une approche intégrée de la conformité, particulièrement pour les systèmes d'IA à haut risque qui nécessitent des données personnelles.

L'intelligence artificielle continue de transformer notre approche de la régulation technologique. Cette évolution s'inscrit dans une dynamique plus large d'innovation et de transformation digitale, comme en témoignent les récentes levées de fonds dans le secteur de l'IA appliquée qui bouleversent des secteurs traditionnels comme la comptabilité.

Perspectives et enjeux géopolitiques

Cette régulation européenne s'inscrit dans un contexte de concurrence technologique mondiale où les approches diffèrent selon les régions. Alors que les États-Unis privilégient une régulation sectorielle plus flexible et que la Chine développe ses propres standards, l'Europe mise sur l'effet "Brussels Effect" pour imposer ses normes à l'échelle mondiale.

Les entreprises technologiques internationales surveillent attentivement ces développements. Les récentes évolutions concernant les partenariats entre grandes entreprises tech et institutions publiques illustrent la complexité croissante des enjeux réglementaires dans le secteur de l'IA.

Conclusion : Un cadre réglementaire en construction

Cette consultation publique marque une étape cruciale dans l'édification du premier cadre réglementaire mondial complet sur l'intelligence artificielle. En impliquant tous les acteurs dans la définition des règles applicables aux systèmes à haut risque, l'Union européenne affirme sa volonté de concilier innovation technologique et protection des citoyens.

Le succès de cette démarche déterminera largement la capacité de l'Europe à s'imposer comme référence mondiale de l'IA responsable. Les mois à venir seront décisifs pour façonner un cadre réglementaire équilibré qui protège les droits fondamentaux sans étouffer l'innovation. L'enjeu dépasse largement les frontières européennes : il s'agit de définir les standards mondiaux d'une intelligence artificielle au service de l'humanité.

✍️ À propos de l'auteur

Sophie Dubois

🎓 Expert IA & Technologie

📅 5+ années d'expérience

✍️ 139+ articles publiés

Journaliste tech spécialisée dans les nouvelles technologies et leur impact business. Ancienne rédactrice chez TechCrunch France.

📅 Article publié le 18 juin 2025 à 18:18

🔄 Dernière mise à jour le 24 juin 2025 à 10:21